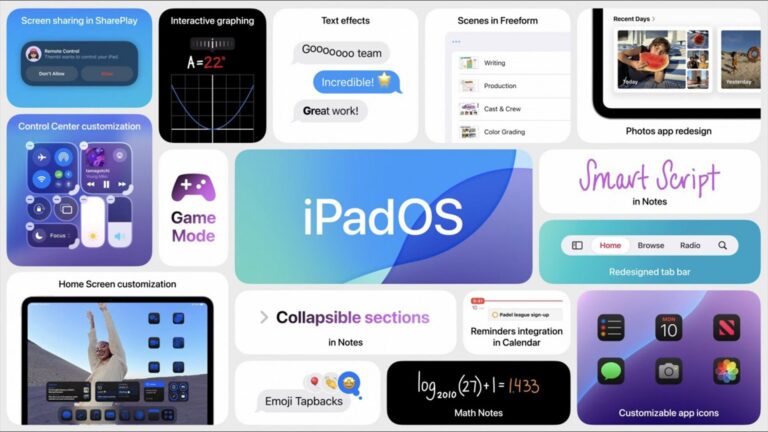

先日にAppleはWWDCを開催して、事前情報通りApple intelligenceを正式発表。他社で見ればGoogle AIやGalaxy AIと「AI」という表現をしていますがAppleの場合はあえてAIという表現を採用していません。

その理由の一つとしてAIはユーザビリティを改善する方法の一つであり自然に動作していることが望ましい。つまり他社のように「機能」とするよりはiOSやiPadOSに深く統合させることでApple製品をより快適に使えるようにすることが目的だとされています。

今回Phone ArenaによるとApple intelligenceがiPhone 15 Proシリーズにしか対応しない理由に言及しているのでまとめたいと思います。

動作条件が高い。

今回Appleのマーケティング部門における幹部であるGreg Joswiak氏によるとApple intelligenceが現時点でiPhone 15 Pro/iPhone 15 Pro Maxに限定していることはAI対応のiPhoneを売ることを目的にしていないことを明らかにしています。

今回Appleのマーケティング部門における幹部であるGreg Joswiak氏によるとApple intelligenceが現時点でiPhone 15 Pro/iPhone 15 Pro Maxに限定していることはAI対応のiPhoneを売ることを目的にしていないことを明らかにしています。

少なくともM1チップに対応したiPadが対応していることからも、Appleが最新のiPhoneやiPadに限定していないことは明白ともいえます。一方でソフトウェアエンジニアリングのトップであるCraig Federighi氏によるとApple intelligenceを動作するためには最低でもRAM8GBが必要であることを明らかにしています。

少なくともApple intelligenceの対象機種がiPhoneで見ればiPhone 15 Proシリーズに限定されている理由としてはRAMなどのハード的要件に加え、機械学習部門のトップであるJohn Giannandrea氏によると動作性だとしています。

少なくともA17 Proを搭載しているiPhone 15 ProシリーズレベルのパフォーマンスがないとAppleが許容できる洗練された体験を提供出来ないことを明らかにしています。

独自SoCの付加価値が高まる可能性。

AppleのAチップが最高クラスのSoCであることに違いはなくベンチマークでもトップクラスですが、それでも最新世代ではないと十分なパフォーマンスを提供出来ないことを考えるとAI性能を測る上でベンチマークスコアは全くあてにならないことになります。

AppleのAチップが最高クラスのSoCであることに違いはなくベンチマークでもトップクラスですが、それでも最新世代ではないと十分なパフォーマンスを提供出来ないことを考えるとAI性能を測る上でベンチマークスコアは全くあてにならないことになります。

またAppleはA18チップなど今後AIを強化する上でSoC自体を自由にカスタマイズすることで強化できる可能性が高く、Googleに関してもだいぶ前からベンチマークを捨ててAIを強化するためにGoogle Tensorに切り替えています。

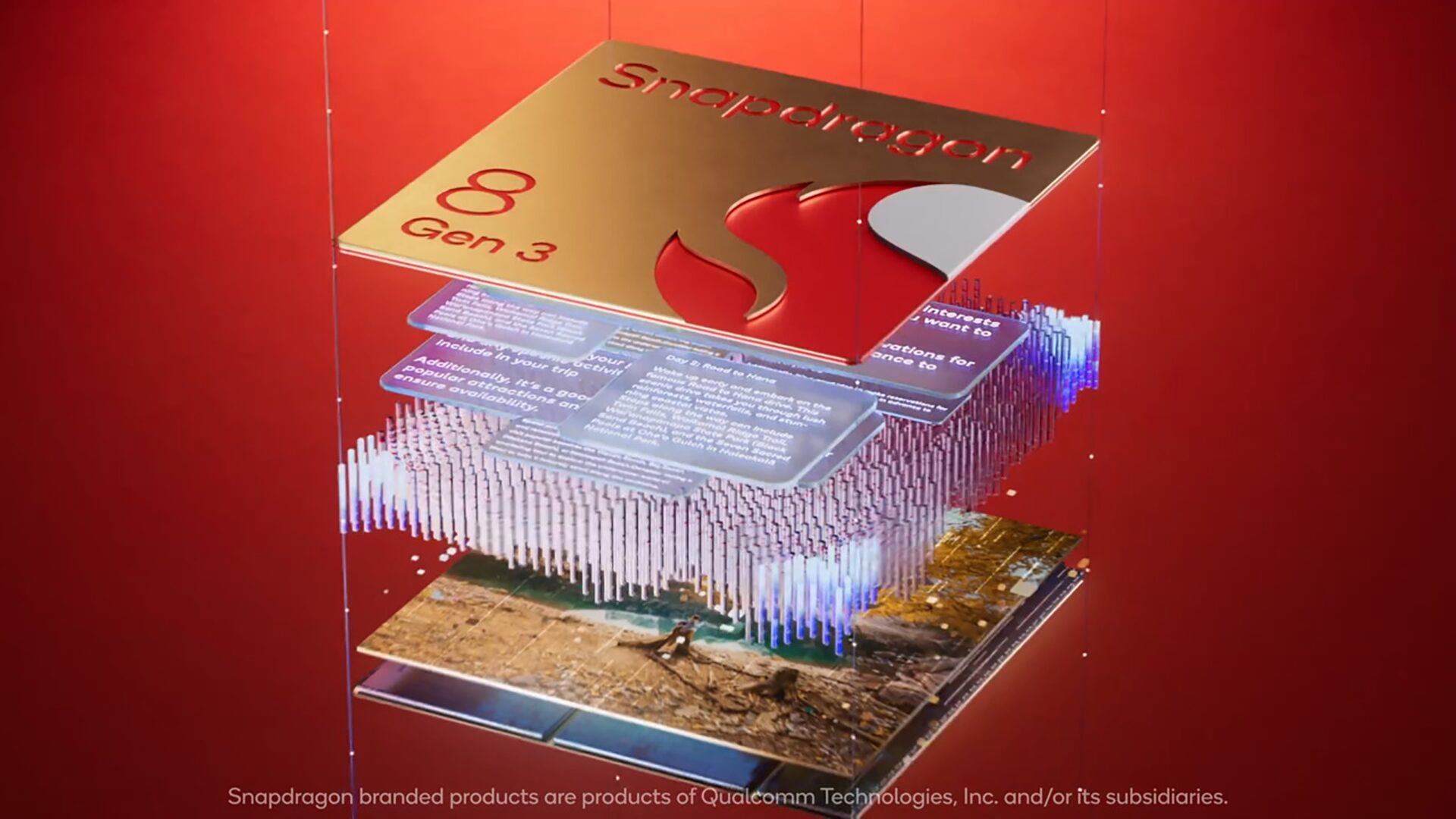

少なくともGoogleがやりたいことをSnapdragonやDimensityで実現できるのであれば莫大なコストをかけてまでGoogle Tensorに切り替えることはなかったと判断することができ、ベンチマークでトップクラスとなるSnapdragon 8 Gen 3やDimensity9300でGoogleがやりたいことを実現できるのであればPixelはGoogle Tensorをやめていてもおかしくないと思います。

QualcommやMediaTekもAI関連機能を強化しているとはいえ、採用するメーカーはSoCの仕様に合わせるしかなく逆にいえばメーカーは自分たちがやりたいことをやりたくてもSoCのパフォーマンスに制限されると思います。

そのため今後本格にAIをより強化するとなった時に既存のSoCだと制限される可能性があり独自SoCの強みがますのかもしれません。